Spark Submit 运行配置

通过 Spark 插件,您可以在 Spark clusters 上执行应用程序。 IntelliJ IDEA 提供运行/调试配置以运行 Spark 的 bin 目录中的 spark-submit 脚本。 您可以在本地或使用 SSH 配置执行应用程序。

安装 Spark 插件

此功能依赖 Spark 插件,您需要安装并启用。

按 Ctrl+Alt+S 打开设置,然后选择 。

打开 Marketplace 选项卡,找到 Spark插件,然后点击 安装 (如果出现提示,请重新启动IDE)。

使用 Spark Submit 配置运行应用程序

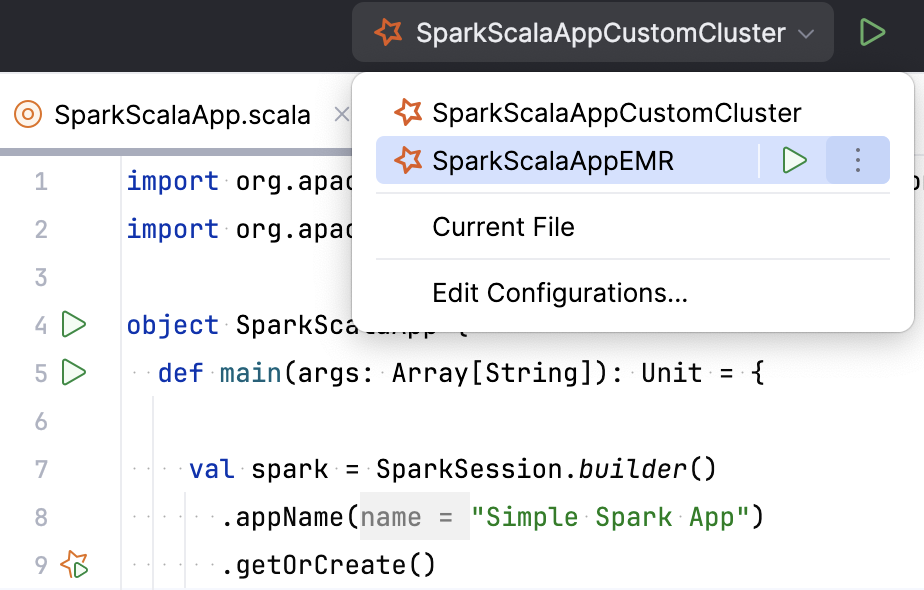

前往 。 或者,按 Alt+Shift+F10 ,然后按 0。

请点击 添加新配置 按钮(

)并选择 。

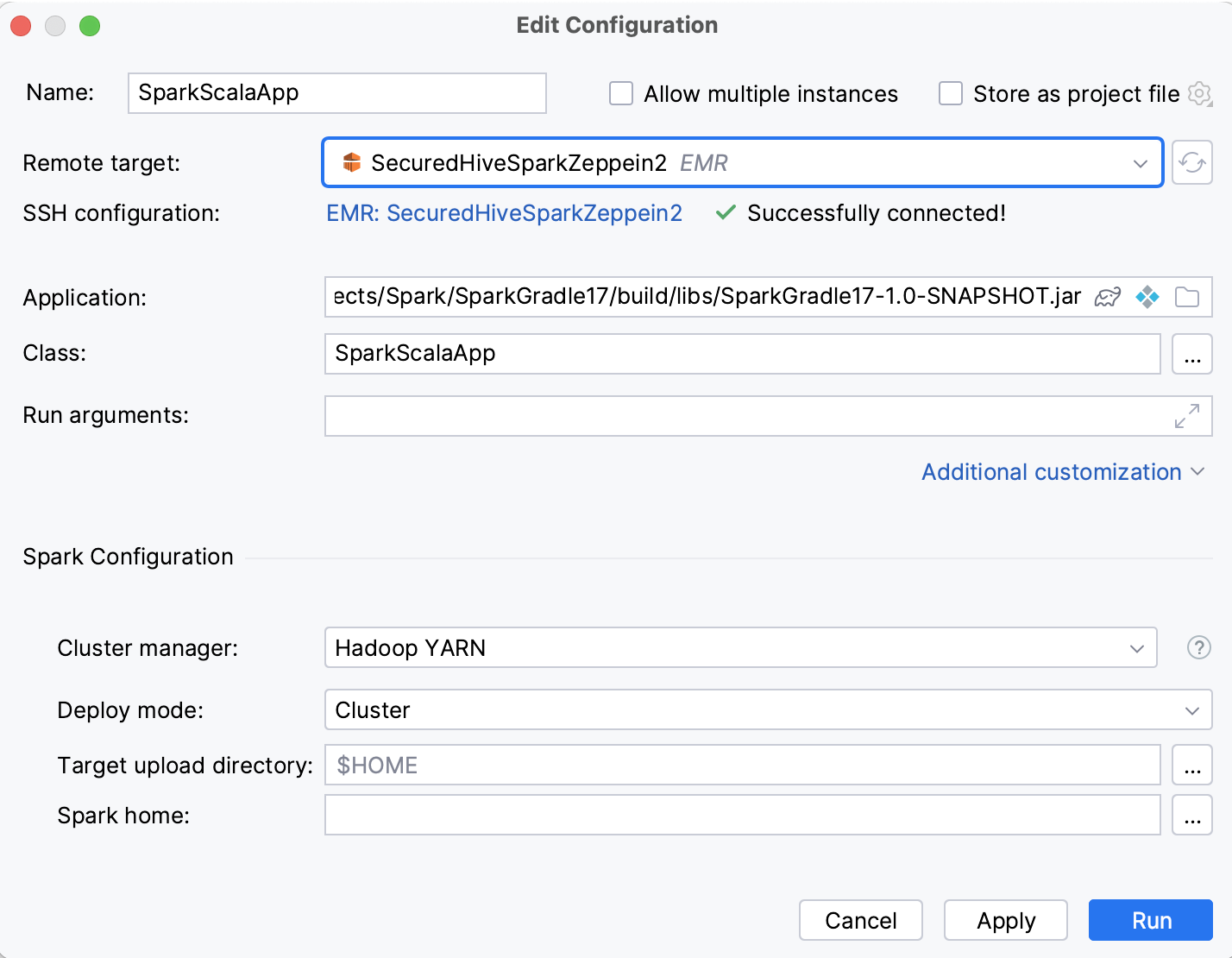

请输入运行配置名称。

在 远程目标 列表中,执行以下操作之一:

如果您已经连接到 AWS EMR 集群 ,您可以将您的应用程序上传到上面。

如果您有 SSH 配置,您可以使用它们将应用程序提交到自定义远程服务器。

否则,请点击 添加 EMR 连接 或 添加 SSH 连接。

在 应用程序 字段中,选择获取应用程序文件的方法:

点击

选择一个 Gradle 任务和 artifact。

点击

选择 一个 IDEA artifact。

或者点击

以从您本地机器上传一个 JAR 或 ZIP 文件。

在 类 字段中,输入应用程序主类的名称。

您还可以指定可选参数:

运行参数 :运行应用程序的参数。

在 Spark 配置 下设置:

集群管理器 :选择在集群上运行应用的管理方法。 SparkContext 可以连接到几种类型的集群管理器(如 Spark 自己的独立集群管理器、Mesos 或 YARN)。 详情请参见 Cluster Mode Overview。

部署模式 :群集或客户端。

目标上传目录 :在远程主机上上传可执行文件的目录。

Spark 主目录 :Spark 安装目录的路径。

配置 :任意 Spark 配置属性,格式为 key=value。

属性文件 :具有 Spark 属性的文件路径。

Spark 调试 (适用于 Java 和 Scala 应用程序):

使用调试代理启动 Spark 驱动程序 :在启动此运行/调试配置时启动 JDWP 代理。 这将允许您在运行应用程序后连接到调试器。 禁用该选项会禁用此配置的调试模式。

侦听端口 :指定服务器上的调试器端口。 留空以在运行时动态分配可用端口。

挂起驱动程序 :挂起 Spark 驱动程序进程,直到调试器附加(

suspend=yJDWP 代理选项)。 仅在调试模式下适用。 在运行模式下,始终使用suspend=n。

在 依赖项 下,选择应用程序执行所需的文件和归档文件( jars )。

在 Maven 下,选择 Maven 特定的依赖项。 您可以添加仓库或从执行上下文中排除某些包。

在 驱动程序 下,选择 Spark Driver 设置,例如用于驱动程序进程的内存量。 在集群模式下,还可以指定核心数。

在 执行器 下,选择执行器设置,例如内存大小和核心数量。

Kerberos :与 Kerberos 建立安全连接的设置。

Shell 选项 :选择是否要在 Spark submit 之前执行任何脚本。

输入 bash 路径并指定要执行的脚本。 建议提供脚本的绝对路径。

如果您希望以交互模式启动脚本,请选中 交互式 复选框。 您还可以指定环境变量,例如

USER=jetbrains。高级提交选项:

代理用户 :已启用用于 Spark 连接代理的用户名。

驱动程序 Java 选项、 驱动程序库路径 和 驱动程序类路径 :添加额外的驱动程序选项。 如需更多信息,请参阅 Runtime Environment。

归档 :要解压缩到每个执行程序的工作目录中的存档的逗号分隔列表。

打印附加调试输出 :运行 spark-submit 并使用

--verbose选项来打印调试信息。

点击 确定 以保存配置。 然后从已创建的配置列表中选择配置并点击

。

在 运行 工具窗口中检查执行结果。

另请参见 在集群上创建并运行 Spark 应用程序 ,了解如何使用此运行配置并监控执行结果。