自定义 Spark 集群

在 Spark Submit 运行配置 中,您可以使用 AWS EMR 或 Dataproc 作为远程服务器来运行您的应用程序。 除了这两个选项之外,您还可以配置自己的自定义 Spark 集群:设置 SSH 配置以连接到远程服务器,并可选地配置到 Spark History 服务器和 SFTP 的连接。

创建自定义 Spark 集群

在 Big Data Tools 窗口中,点击

,然后选择 自定义 Spark 集群。

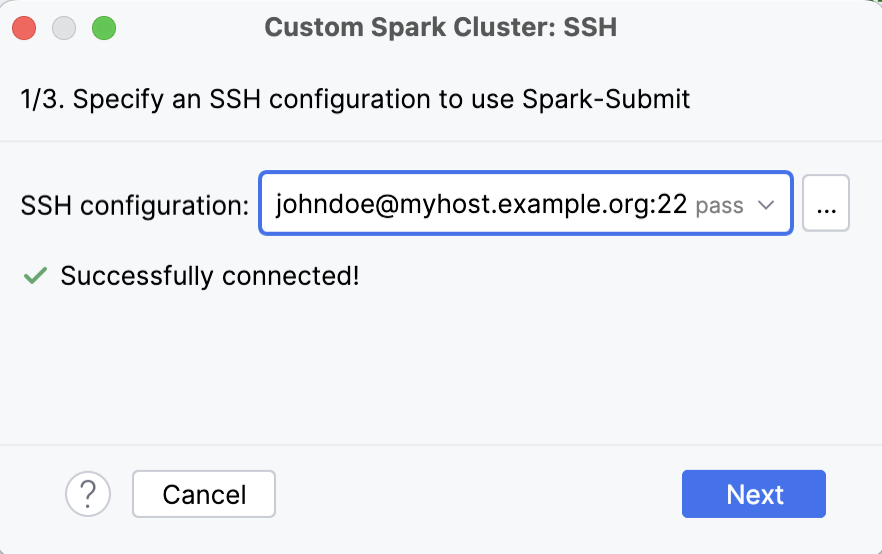

在打开的窗口的第一步中,选择一个 SSH 配置并点击 下一步。 此 SSH 配置将用于连接到已安装 spark-submit 的服务器。

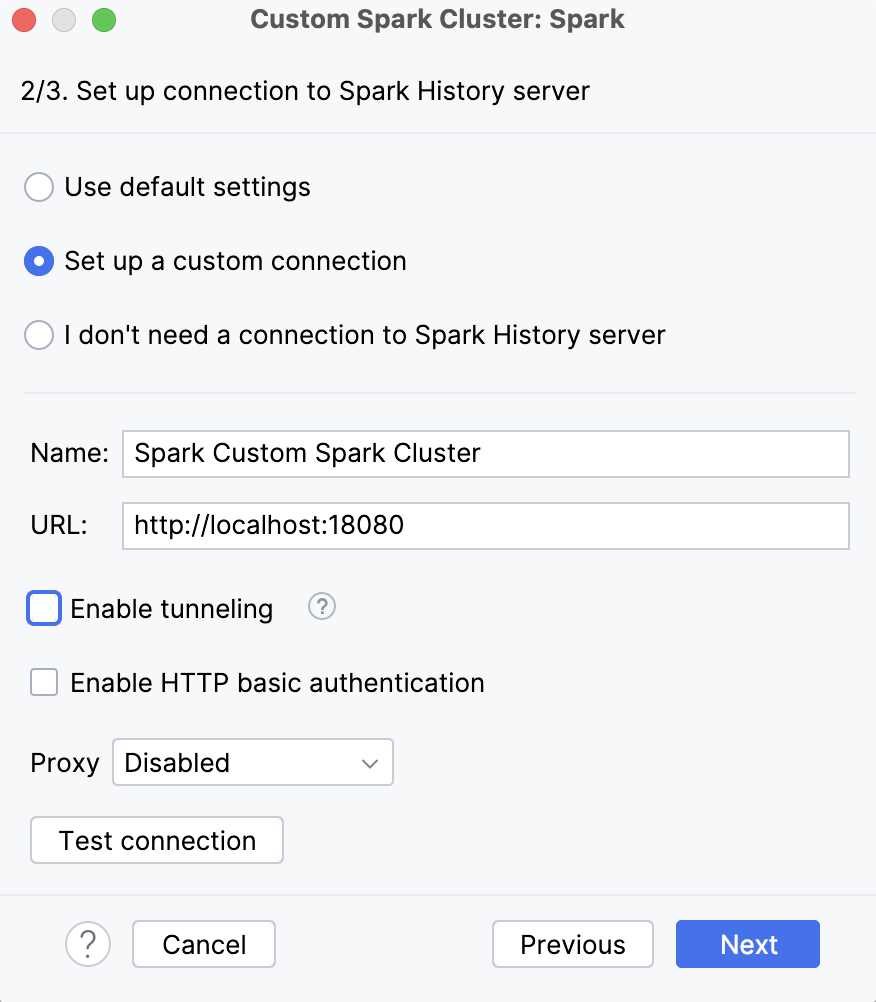

如果您希望在 IDE 中 监控 Spark 作业 ,请在向导的第二步中指定用于与 Spark History 服务器建立连接的参数。 指定您的自定义参数,或使用默认设置,这将通过 SSH 隧道创建到

localhost:18080的连接。否则,选择 不需要与 Spark 历史服务器建立连接。

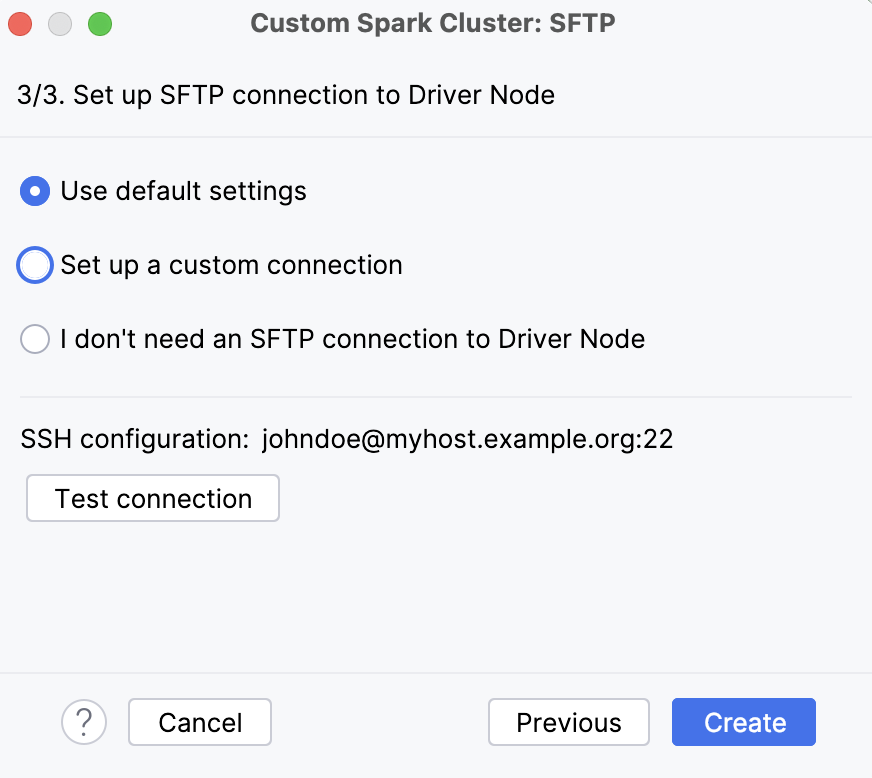

如果您需要到 Spark 集群的 SFTP 连接,请在向导的第三步中指定其设置。

否则,选择 不需要与 Driver 节点建立 SFTP 连接。

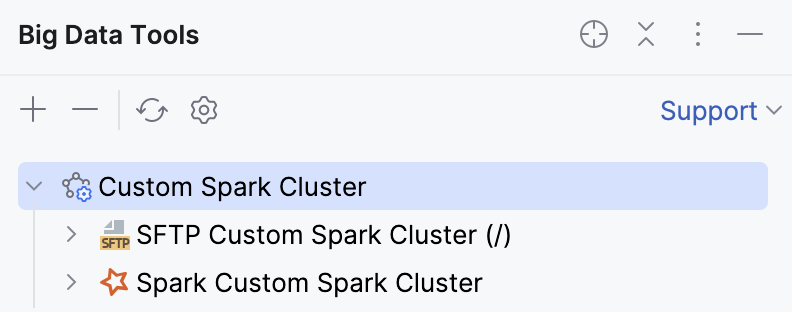

如果您同时设置了 Spark History 和 SFTP 连接,它们将在 自定义 Spark 集群 下,在 Big Data Tools 工具窗口中可用。

现在,您可以在 Spark Submit 运行配置 中将此集群选择为远程目标。 启动此运行配置后,您可以在应用程序输出中点击链接,在 服务 工具窗口中打开 Spark 作业。

最后修改日期: 2025年 12月 2日