HDFS

安装 Remote File Systems 插件

此功能依赖 Remote File Systems 插件,您需要安装并启用它。

按 Ctrl+Alt+S 打开设置,然后选择 。

打开 Marketplace 选项卡,找到 Remote File Systems 插件,然后点击 安装 (如果出现提示,请重启 IDE)。

连接到 HDFS 服务器

在 Big Data Tools 窗口中,点击

,然后选择 HDFS。

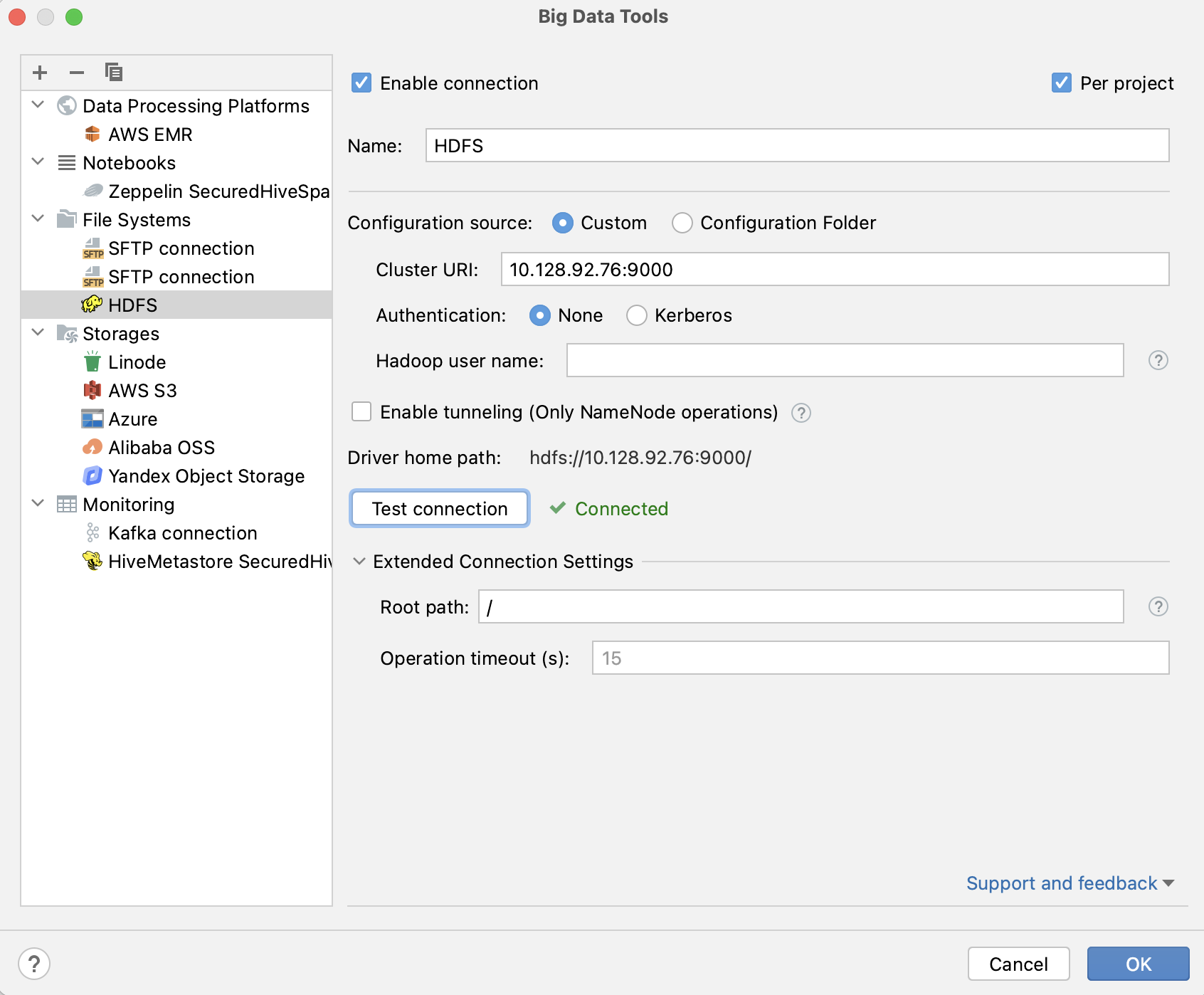

在打开的 Big Data Tools 对话框中,指定连接参数:

名称 :连接名称,用于将其与其他连接区分开。

在 配置源 中,选择以下之一:

可选:您可以设置:

按项目 :选择后,仅为当前项目启用这些连接设置。 如果希望此连接在其他项目中可见,请清除此复选框。

启用连接 :如果希望禁用此连接,请清除此复选框。 默认情况下,新建的连接处于启用状态。

Hadoop 用户名 :输入用于登录服务器的用户名。 如果未指定,则使用

HADOOP_USER_NAME环境变量。 如果未定义该变量,则使用user.name属性。 如果启用 Kerberos,则会覆盖上述三者中的任意值。启用隧道(仅 NameNode 操作)。 此选项会创建到远程主机的 SSH 隧道。 如果目标服务器位于私有网络中,但可以通过 SSH 连接到该网络中的某台主机,则此功能会很有用。 目前,SSH 隧道仅适用于以下 NameNode 的操作:列出文件、获取元信息。

选中该复选框并指定 SSH 连接的配置(点击 ... 创建新的 SSH 配置)。

在 扩展连接设置 下,您可以设置:

根路径 :目标服务器上作为 HDFS 连接根目录的路径。

操作超时(秒) :为在远程存储上执行的操作输入超时时间(以秒为单位),例如获取文件信息、列出或删除对象。 默认值为 15 秒。

填写完设置后,点击 测试连接 以确保所有配置参数均正确。 然后点击 确定。

连接成功建立后, 驱动程序主路径 字段会显示连接的目标 IP 地址,包括端口号。 示例: hdfs://127.0.0.1:65224/ 。

Hadoop 文件系统配置文件示例

类型 | 示例配置 |

|---|---|

HDFS |

<?xml version="1.0"?>

<configuration>

<property>

<name>fs.hdfs.impl</name>

<value>org.apache.hadoop.hdfs.DistributedFileSystem</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://example.com:9000/</value>

</property>

</configuration>

|

S3 |

<?xml version="1.0"?>

<configuration>

<property>

<name>fs.s3a.impl</name>

<value>org.apache.hadoop.fs.s3a.S3AFileSystem</value>

</property>

<property>

<name>fs.s3a.access.key</name>

<value>sample_access_key</value>

</property>

<property>

<name>fs.s3a.secret.key</name>

<value>sample_secret_key</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>s3a://example.com/</value>

</property>

</configuration>

|

WebHDFS |

<?xml version="1.0"?>

<configuration>

<property>

<name>fs.webhdfs.impl</name>

<value>org.apache.hadoop.hdfs.web.WebHdfsFileSystem</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>webhdfs://master.example.com:50070/</value>

</property>

</configuration>

|

WebHDFS 和 Kerberos |

<?xml version="1.0"?>

<configuration>

<property>

<name>fs.webhdfs.impl</name>

<value>org.apache.hadoop.hdfs.web.WebHdfsFileSystem</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>webhdfs://master.example.com:50070</value>

</property>

<property>

<name>hadoop.security.authentication</name>

<value>Kerberos</value>

</property>

<property>

<name>dfs.web.authentication.kerberos.principal</name>

<value>testuser@EXAMPLE.COM</value>

</property>

<property>

<name>hadoop.security.authorization</name>

<value>true</value>

</property>

</configuration>

|