Spark DataFrame 编码辅助

Spark 插件为您的 Scala 和 Python 代码中的 Apache Spark DataFrames 提供编码支持。

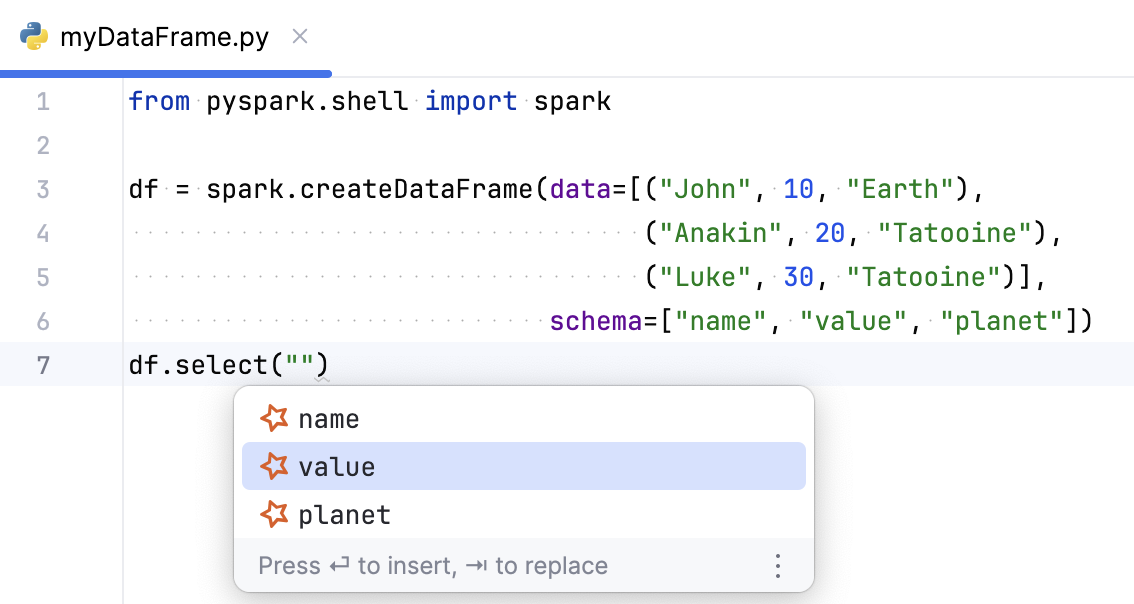

可用列的补全

如果您创建了一个 DataFrame 或从文件中读取它,IntelliJ IDEA 将帮助您访问 DataFrame 的列,例如,在选择或过滤 DataFrame 时。

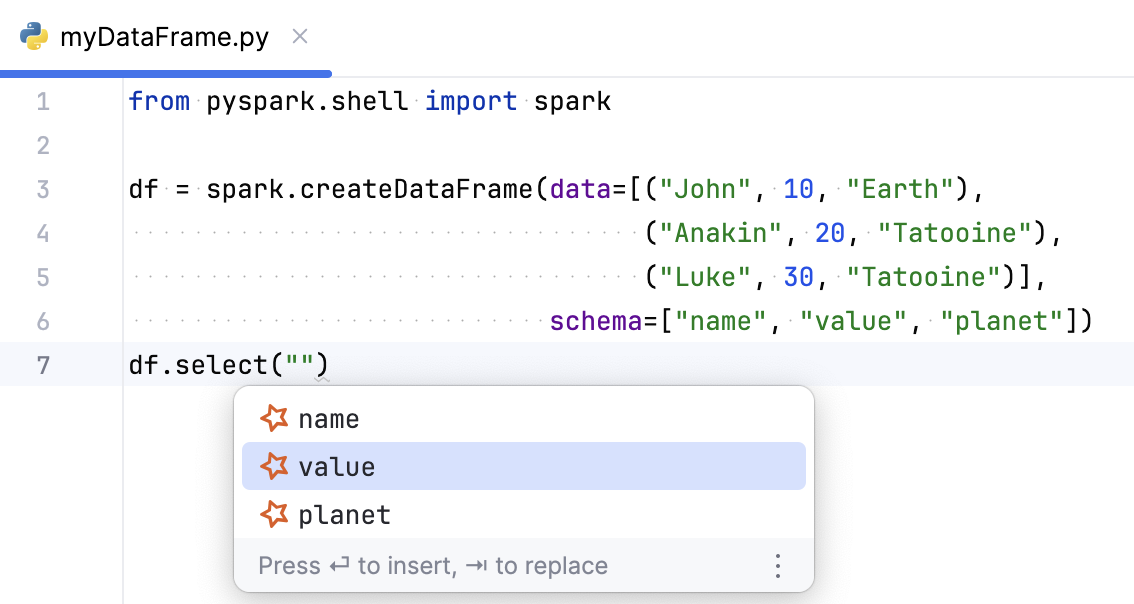

检测未解析的列

如果您引用了 DataFrame 中不存在的列,IntelliJ IDEA 会高亮显示它,并建议将其替换为现有的列名之一。

您可以在 IDE 设置(Ctrl+Alt+S )中启用和禁用此检查,位于 下。

获取模式

如果 IntelliJ IDEA 可以访问 DataFrame 架构,则可提供列名的补全和相应的检查。 模式可以通过多种方式指定:

列及其类型直接在

read方法中指定:df = (spark.read .schema("name STRING, value BIGINT, planet STRING") .parquet("aliens.parquet")) .parquet("aliens.parquet"))架构被指定为一个单独的变量,然后在

read方法中使用:schema = StructType([ StructField("name", StringType(), False), StructField("value", LongType(), False), StructField("planet", StringType(), False), ]) df = spark.read.schema(schema).parquet("aliens.parquet")

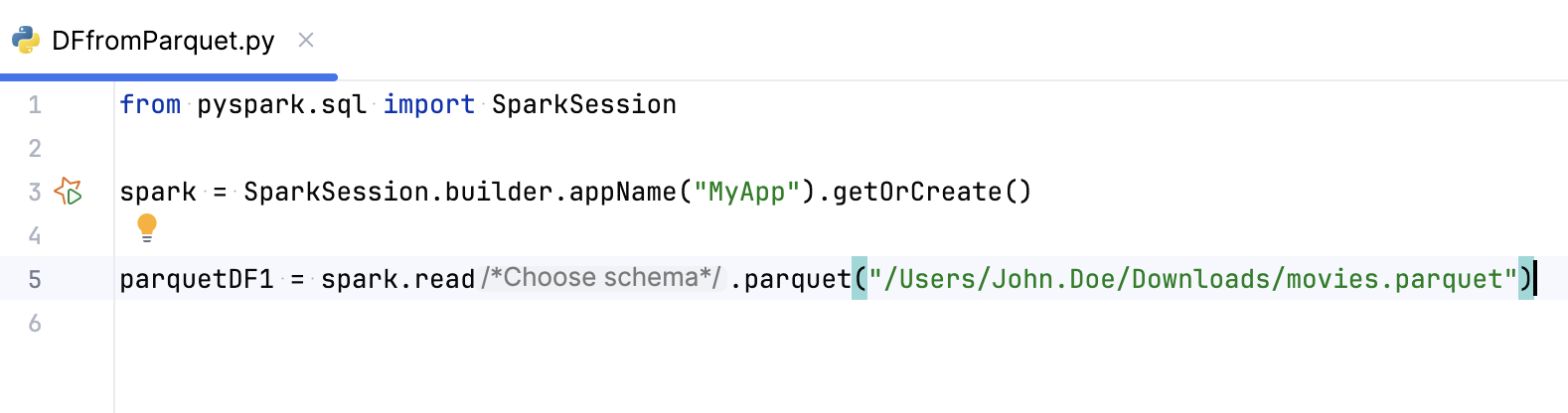

如果您没有通过以上任何一种方式指定架构,您可以使用专用的内嵌提示从 Parquet 文件推断架构。 该文件可以位于本地或远程存储上。

从文件推断架构

在您的 Spark 代码中使用

read.parquet()方法,例如:df = spark.read.parquet("/myfilepath")点击

Choose schema内联提示。

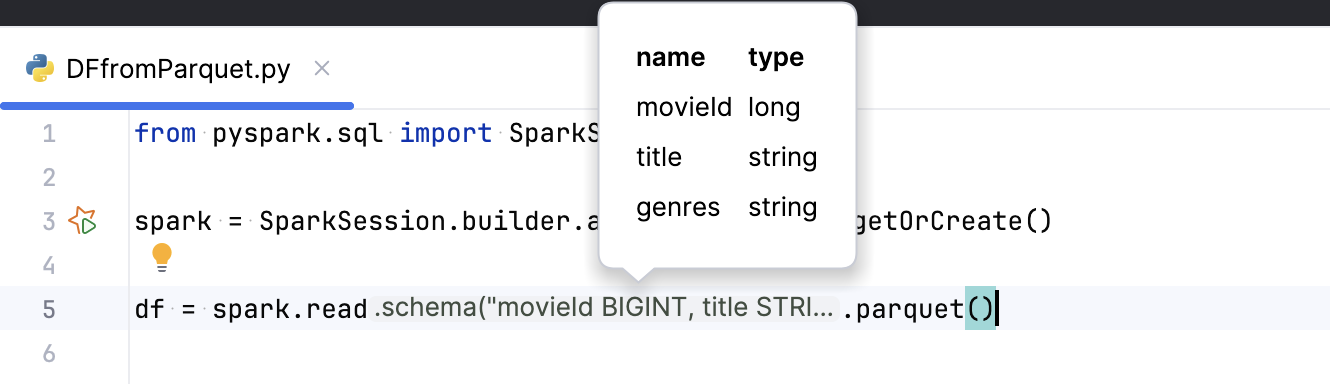

在打开的窗口中,选择一个可以推断模式的文件。

从选定文件推断的模式将作为内嵌提示显示在方法旁边。 您可以将鼠标悬停在它上面预览可用的列及其类型。 您可以点击它来插入架构,使用

schema方法或选择另一个。

您可以在 IDE 设置(Ctrl+Alt+S )中启用或禁用此内嵌提示,Python 的设置位于 ,Scala 的设置位于 。

2026年 1月 23日